Les machines qui génèrent des films

Restons dans le domaine de l’IA générative et intéressons-nous cette fois-ci à l’évolution des images animées, depuis leurs débuts jusqu’aux usages actuels.

Aux origines du cinéma

On attribue généralement l’invention du cinéma aux frères Lumière, qui ont présenté leur premier film le 28 décembre 1895 à Paris. Mais il est moins connu que Louis Ducos du Hauron (1837-1920), déjà pionnier de la photographie en couleurs, avait exploré dès la fin du XIXe siècle des procédés de photographie séquentielle qui préfiguraient les techniques cinématographiques. Ses travaux ont jeté les bases de l’image animée bien avant son exploitation commerciale par les frères Lumière.

Les premiers dessins animés

L’histoire des films animés prend un tournant en 1928 avec la sortie de Steamboat Willie, le premier dessin animé à bénéficier d’une bande sonore synchronisée. Ce court-métrage introduit au public le personnage de Mickey Mouse, devenu un véritable symbole de la culture populaire. Le film fut animé par Ubbe Ert Iwwerks (1901-1971), surnommé la « main magique » de Walt Disney. Après une brève carrière indépendante, il revint dans les années 1940 chez Disney, non plus comme animateur, mais comme ingénieur en effets spéciaux, contribuant à des innovations techniques qui ont marqué des films cultes du studio.

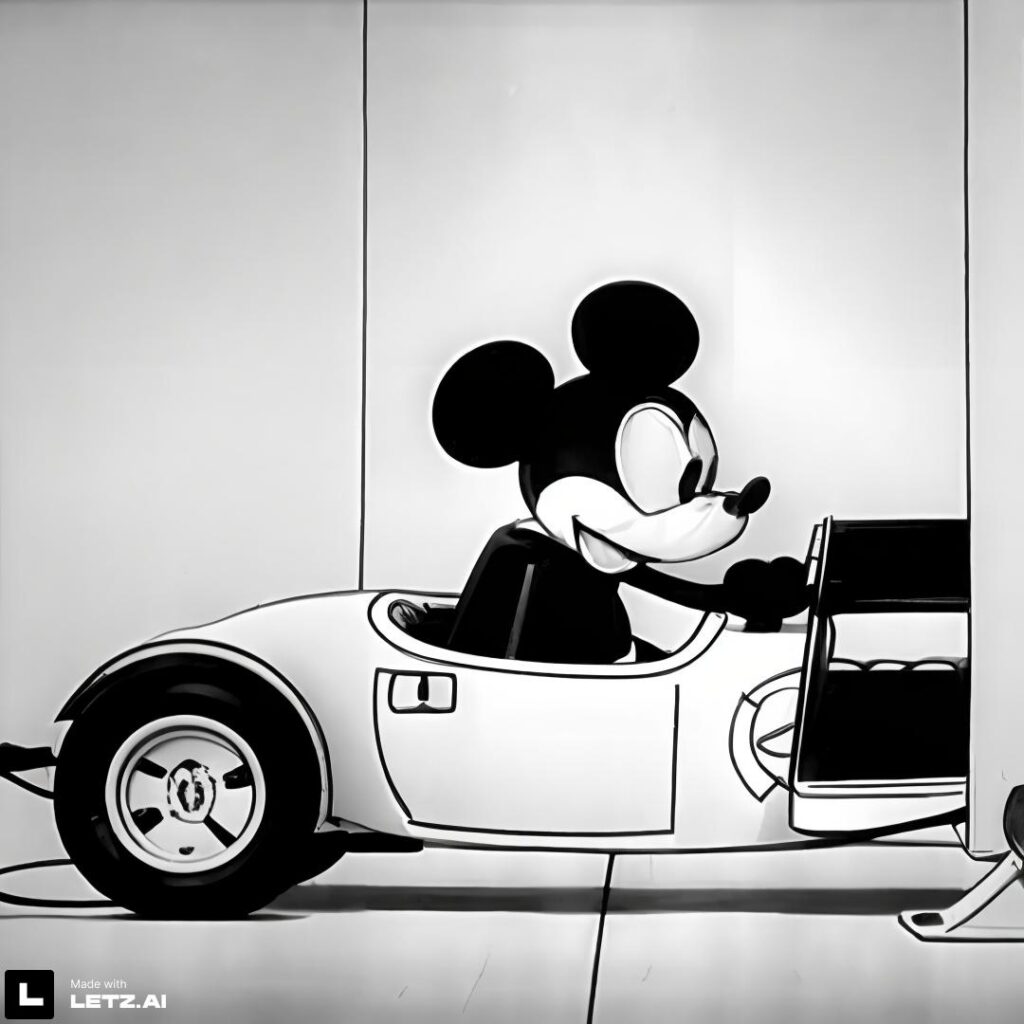

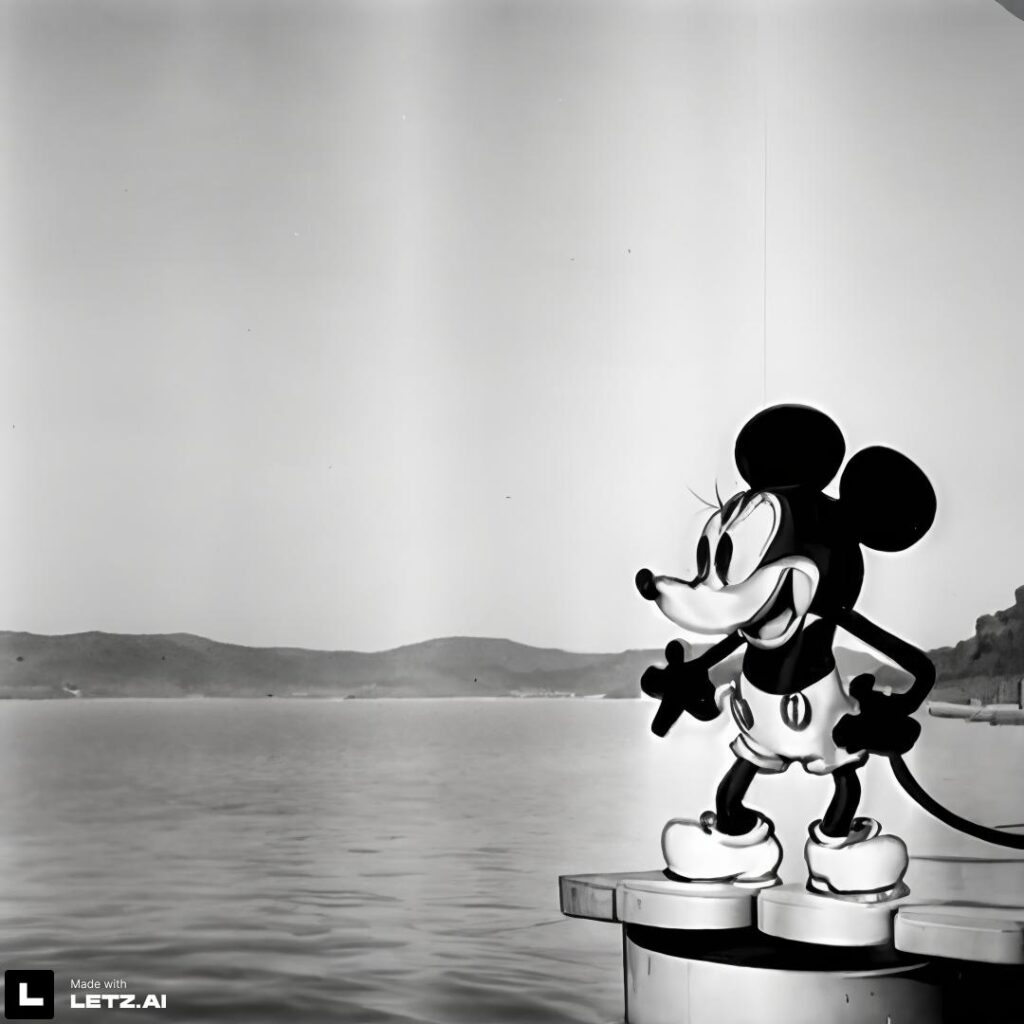

Steamboat Willie et l’IA générative

Le film joue aujourd’hui un rôle particulier dans le contexte de l’IA générative. En 2023, les droits d’auteur sur le premier Mickey Mouse sont arrivés à expiration. 75 ans après sa publication, l’œuvre est tombée dans le domaine public. Cette libération juridique a ouvert la voie à de nouveaux usages créatifs : par exemple, les utilisateurs de LetzAI ont pu entraîner légalement un modèle inspiré de ce Mickey originel et l’imaginer dans des scènes contemporaines. Ci-dessous, quelques images générées par le créateur luxembourgeois Biitz en témoignent.

E.T., un autre jalon de l’innovation

Un autre film emblématique est E.T. l’extra-terrestre de Steven Spielberg (1982), chef-d’œuvre du cinéma de science-fiction. À l’époque, les technologies de synthèse 3D n’étaient pas encore assez avancées pour créer un personnage numérique crédible. Steven Spielberg fit donc appel à une combinaison de marionnettes, d’animatronique et de performances humaines. Trois personnes ont incarné E.T. : Pat Bilon (1,22 m), acteur atteint de nanisme, Tamara De Treaux (0,84 m), également actrice atteinte de nanisme et Matthew DeMeritt, un adolescent né sans jambes.

Le résultat fut si convaincant qu’E.T. devint une icône universelle, prouvant qu’avant l’ère numérique, l’imagination et l’ingénierie pouvaient donner vie à des personnages inoubliables.

Paddington, l’ours en CGI qui a conquis le cinéma

Dans un registre plus récent, l’exemple de Paddington illustre l’évolution spectaculaire de l’animation par ordinateur. Inspiré du personnage créé par Michael Bond en 1958, l’ours péruvien amateur de marmelade a été adapté au cinéma par Paul King dans deux longs-métrages à succès, en 2014 et en 2017.

Contrairement à E.T., qui était animé par marionnettes et acteurs costumés, Paddington est un personnage généré entièrement en CGI (Computer-Generated Imagery). Son intégration réaliste dans des scènes tournées avec de véritables acteurs a nécessité un travail colossal de la part des studios Framestore. Les animateurs ont accordé une attention méticuleuse aux détails : la texture de sa fourrure, ses expressions faciales, ses gestes maladroits mais attendrissants. Résultat : Paddington a su émouvoir le public tout en se fondant parfaitement dans un univers réel.

Rencontre avec la Reine Élisabeth II

L’ours numérique a atteint un sommet symbolique lors des célébrations du Platinum Jubilee de la Reine Élisabeth II, en juin 2022. Une courte vidéo diffusée à l’ouverture du concert officiel montrait Paddington prenant le thé avec la Reine au palais de Buckingham. Dans ce sketch devenu viral, l’ours maladroit renverse du thé, partage un sandwich à la marmelade et frappe ensuite sa tasse à la cuillère pour donner le rythme à « We Will Rock You » de Queen, repris par l’orchestre militaire et le public.

Mes premiers films CGI

Entre 2019 et 2021, je me suis amusé à créer moi-même quelques films d’animation avec les technologies disponibles à l’époque.

👉 Premier exemple : les DigiBirds.

J’ai utilisé des oiseaux animatroniques interactifs qui bougeaient le bec et la tête, et qui pouvaient chanter en chœur lorsqu’on sifflait. Il s’agissait des DigiBirds de Silverlit, commercialisés à partir de 2014. Ces petits robots-jouets, capables de réagir à des stimuli sonores, peuvent être vus comme une forme très primitive d’intelligence artificielle.

👉 Deuxième exemple : Le GenPet Piccini

J’ai créé un modèle 3D nommé Piccini, en hommage à la sculptrice australienne Patricia Piccinini, connue pour ses créatures hybrides en silicone qui interrogent les limites de la bioéthique et de la biotechnologie. Pour tourner la vidéo, j’avais posé une maquette en carton de la créature sur mon canapé, afin de disposer d’un repère visuel pendant l’enregistrement avec mon iPhone fixé sur un trépied.

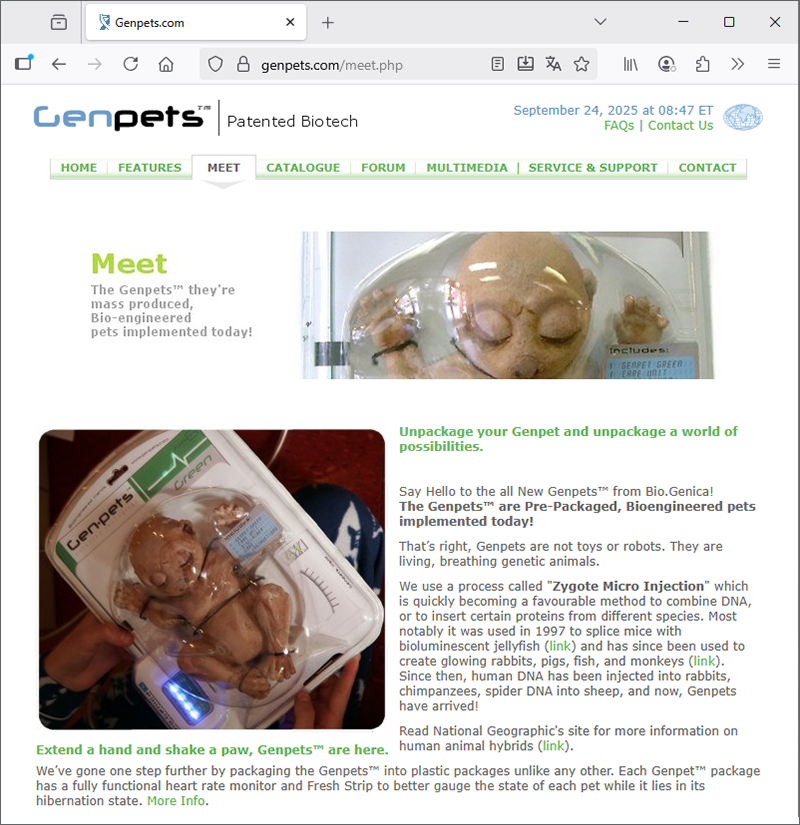

Le «GenPet» qu’on aperçoit dans le film est une œuvre d’art lancée en 2005 par l’artiste canadien Adam Brandejs. Ces sculptures animatroniques en latex, plastique et circuits électroniques simulaient de subtils signes de vie : respiration, tremblements, mouvements limités. Présentées comme des animaux bio-ingénierés pré-emballés, elles étaient accompagnées d’un faux site web, d’emballages sous blister, de « jauges de vitalité » et d’accessoires fictifs. Tout était conçu pour être crédible et provoquer la confusion entre art, science et marketing.

Chaque Genpet était proposé avec des « traits de personnalité » codés par couleur (rouge, bleu, violet, etc.) qui influaient sur son comportement supposé.

Les Genpets ont été exposés dans plusieurs galeries d’art contemporain au Canada et en Europe. En 2007, j’ai acquis un Genpet violet auprès de l’artiste, qui a même remplacé le câble d’alimentation canadien par un modèle européen avant de me l’envoyer. Mon Genpet « dort » toujours dans son état d’hibernation, et le site officiel genpets.com reste en ligne. Cette œuvre est aujourd’hui considérée comme l’un des exemples les plus marquants d’hoax artistique.

Au fond, il s’agit d’une fake news avant l’heure, une fiction conçue pour questionner notre rapport à la biotechnologie et qui résonne aujourd’hui à l’ère de l’IA générative.

👉 Troisième exemple : Google Search AR

À partir de 2019, Google a permis de placer dans son salon, grâce à la réalité augmentée, des animaux ou objets 3D visibles à travers l’appareil photo d’un smartphone. Parmi le catalogue proposé, j’avais choisi un panda. J’ai réglé sa taille et sa position de manière à le faire asseoir sur mon canapé, puis je me suis installé à côté de lui pour simuler une conversation.

Les premiers films IA

À partir de 2022, une nouvelle révolution a commencé : l’IA générative appliquée à la vidéo. On n’avait plus besoin de caméra, de figurines animées ou de dizaines d’outils CGI sophistiqués. Un simple texte suffisait.

Novembre 2023 : sont apparus les premiers outils Image2Video, qui permettaient d’animer directement des images fixes générées par IA. J’ai ainsi pu donner vie aux premières créations LetzAI.

Septembre 2024 : les modèles se sont encore affinés. J’ai pu assembler plusieurs scènes à partir de portraits LetzAI, publiés par l’artiste Savitar Storm (plus de 16.500 images à l’époque, plus de 100.000 aujourd’hui). Un exemple parfait de la puissance… et du côté addictif de ces technologies.

Novembre 2024 : j’ai partagé sur les réseaux sociaux mon premier court-métrage sans caméra, racontant la visite d’un site UNESCO par trois protagonistes de mon livre « Les Jeunes Explorateurs ».

- Animation : réalisée avec Vidu Studio et KLING AI.

- Texte : écrit par ChatGPT.

- Son : bruitages générés avec Meta Audiobox, voix off choisies dans la librairie ElevenLabs.

- Images fixes : créées avec LetzAI, servant de points d’ancrage visuels.

La vidéo ci-dessous montre successivement la version KLING, puis la version VIDU, ce qui permet de comparer leurs forces et faiblesses.

Enfin, j’ai généré l’affiche du film avec LetzAI, en utilisant le modèle de style « @japanese_movie_poster » partagé par Misch Strotz.

Pour conclure ce chapitre, je présente quelques créations professionnelles réalisés avec des outils IA dans le cadre de campagnes de sensibilisation des jeunes sur les risques des informations sur les réseaux sociaux lancés par l’initiative gouvernementale BEE SECURE au courant des années 2024 et 2025.

Vidéos BEE SECURE

Deep Fakes

Deep Fakes : une menace de désinformation accrue.

Cornhub

Pornographie : ce n’est pas le reflet de la réalité.

Sextorsion

Sextorsion : quand l’intimité devient une arme.

Romance Scam

Romance Scam : l’amour utilisée pour arnaquer.