Applications de l’IA

Née officiellement en 1956, l’intelligence artificielle (IA) appartient à une génération d’innovations qui ont marqué l’histoire des technologies modernes. Je la considère comme faisant partie de la génération “Baby-Boomers” des humains. Toutefois, rien n’est vraiment « artificiel » dans l’IA : elle est façonnée par les mains, les données et les choix des humains. Qualifier cette intelligence d’« artificielle » peut parfois donner l’illusion que l’humanité n’en porte pas la responsabilité.

Aujourd’hui, certains chercheurs préfèrent parler d’intelligence numérique ou d’intelligence non organique. Cependant, comme le terme « intelligence artificielle » est largement répandu dans les médias et le grand public, je l’emploie ici sur ce portail KI-Léierbud.

Pour expliquer ce que l’on peut faire avec l’IA, il est utile de retracer brièvement son évolution. Les lecteurs intéressés pourront approfondir l’histoire de l’IA dans d’autres contributions disponibles sur ce portail.

La conférence de Dartmouth (1956)

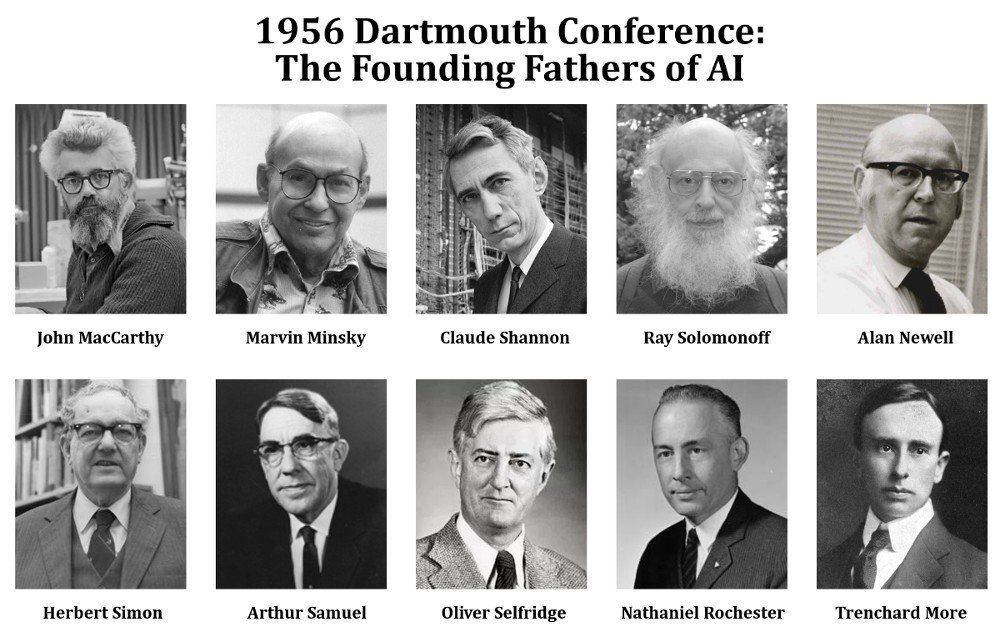

Le terme intelligence artificielle a été proposé pour la première fois en 1956 par John McCarthy (Dartmouth College), lors de la conférence de Dartmouth aux États-Unis (juin à août 1956), co-organisée par Marvin Minsky (Harvard University), Nathaniel Rochester (I.B.M. Corporation) et Claude E. Shannon (Bell Telephone Laboratories). Parmi les autres participants figuraient Trenchard More, Alan Newell, Arthur Samuel, Oliver Selfridge, Herbert Simon et Ray Solomonoff.

Une fameuse photo de la conférence de Dartmouth, affichée ci-après, présente les organisateurs et quelques participants. Le nom du photographe exact de cette image n’est pas clairement documenté dans les archives historiques accessibles.

L’illustration suivante circule largement sur internet, notamment dans des articles, des blogs et des présentations pédagogiques sur l’histoire de l’intelligence artificielle, mais il n’existe pas de crédit d’auteur unique ou officiel pour ce montage particulier. Ce qui est très particulier avec ce montage est le fait que la dernière photo (en bas à droite) ne représente pas le mathématicien et informaticien Trenchard More, mais un instructeur en physique au même nom qui est décédé 12 ans avant la conférence de Dartmouth. L’erreur est le résultat d’une mauvaise recherche sur Google qui confirme que non seulement l’IA peut fournir des informations erronées, mais également les humains.

Les idées majeures abordées lors de la conférence de Dartmouth sont :

- Les réseaux de neurones

- La résolution générale de problèmes

- L’apprentissage automatique

- La perception

- Le langage naturel

La proposition originale d’organisation d’une conférence sur l’IA peut être consulté dans les archives.

Les réseaux de neurones évoqués s’inspiraient du modèle mathématique et informatique du neurone proposé par Warren McCulloch et Walter Pitts (1943). La résolution de problèmes était notamment influencée par la machine de Turing, imaginée par Alan Turing (1936).

L’IA symbolique (1956–1973)

La première application concrète de l’IA fut Logic Theorist, présenté peu après la conférence de Dartmouth. Ce programme, souvent considéré comme le premier logiciel d’IA, démontrait des théorèmes en logique symbolique. D’autres projets ont suivi, mais les ordinateurs de l’époque étaient trop lents, la mémoire trop coûteuse, et les ressources humaines limitées pour atteindre les ambitions affichées.

Premier hiver de l’IA (1974–1979)

Les résultats décevants des projets des années 1960 entraînèrent une réduction des budgets de recherche en IA, notamment en Europe et aux États-Unis. L’IA fut marginalisée au profit de l’informatique classique.

L’âge d’or des systèmes experts (1980–1986)

Au début des années 1980, les systèmes experts connurent un succès commercial. Des entreprises et des gouvernements investirent massivement, espérant en faire des outils révolutionnaires. Cette période marqua une sortie du premier hiver de l’IA, avec des avancées également permises par l’apprentissage statistique et la redécouverte des réseaux neuronaux.

Deuxième hiver de l’IA (1987–1992)

Les systèmes experts se révélèrent rigides, coûteux à entretenir et difficiles à adapter à de nouveaux problèmes.

Les attentes liées aux ordinateurs de cinquième génération furent déçues, et le marché des outils IA s’effondra, entraînant un second hiver.

Montée de l’apprentissage automatique (1993–2009)

La sortie de cet hiver fut portée par le succès de nouvelles méthodes d’apprentissage statistique : réseaux bayésiens, arbres de décision, machines à vecteurs de support (SVM). Les réseaux neuronaux bénéficièrent de la généralisation de l’algorithme de rétropropagation. Des applications solides émergèrent : détection de fraude, lecture optique de caractères (OCR), surveillance automatisée…

Basculement vers l’apprentissage profond (2010–2016)

Grâce à la puissance des cartes graphiques (GPU) et aux jeux de données massifs (par exemple ImageNet), l’apprentissage profond a surpassé les méthodes traditionnelles, notamment en vision par ordinateur et en traitement du langage. Les architectures notables : réseaux convolutifs (CNN), réseaux récurrents (RNN, LSTM), réseaux antagonistes génératifs (GAN), autoencodeurs…

L’ère des transformateurs (2017–2022)

Les transformateurs (transformers : BERT, GPT, etc.) ont révolutionné le traitement du langage naturel. Ils ont permis des performances inédites dans des tâches complexes : traduction, résumé automatique, dialogue…

Tsunami IA (2023 et au-delà)

Depuis fin 2022, avec l’essor des grands modèles de langage (LLM) comme ChatGPT, l’IA entre dans une phase de diffusion massive et rapide qui transforme de nombreux secteurs de la société.

Conclusion

De la démonstration de théorèmes au dialogue avec des assistants numériques, l’IA a parcouru un chemin impressionnant. Elle offre aujourd’hui un vaste champ d’applications, des plus simples aux plus sophistiquées, mais reste une œuvre humaine, dont nous sommes collectivement responsables.